Rapport Racine sur la création : pourquoi les bibliothèques devraient davantage s’y intéresser

En janvier dernier, le rapport « L’auteur et l’acte de création » a été remis par Bruno Racine au Ministère de la Culture. J’avais publié à ce moment un premier billet de réaction, en me focalisant sur un point précis du rapport : le rejet de la proposition du domaine public que j’avais salué. Mais ce document comporte bien d’autres qui méritaient à mon sens de s’y pencher, si possible avec la perspective particulière du bibliothécaire qui est la mienne.

Je n’avais trouvé l’occasion de le faire depuis janvier, mais cette lacune est réparée grâce à l’IFLA (la Fédération Internationale des Associations et Institutions de Bibliothèques) qui avait repéré la parution de ce rapport et qui m’a demandé de répondre à quelques questions à ce sujet. Il en a résulté une interview, publiée cette semaine sur leur site et traduite en anglais (merci à Camille Françoise pour cela !).

Le rapport Racine n’a pas réellement entraîné de réactions de la la part des principales associations de bibliothécaires en France, ce qui est à mon sens un tort. Ce texte constitue un mon sens un des apports les plus importants que l’on ait vu passer ces dernières années sur la question de l’évolution du droit d’auteur. Et je vais même aller plus loin : c’est même sans doute la proposition la plus forte à avoir été faite depuis le projet de réforme – hélas avortée – tentée par Jean Zay en 1936 à l’époque du Front Populaire. Je fais cette comparaison à dessein, car il existe une forme de filiation intellectuelle assez claire entre les deux, notamment sur la question de l’articulation entre la question de la création et celle du travail (sujet que j’ai abordé aussi parfois sur ce blog). A mon sens, Il y a dans le rapport Racine rien de moins que des pistes pour faire advenir un droit d’auteur « post-Beaumarchais » et ce n’est pas exactement rien.

Quel rapport avec les bibliothèques, me direz-vous ? Il en existe – et de nombreux – et je vous propose de lire le texte de l’interview que j’ai donnée à l’IFLA dont je colle ci-dessous la version en français. La crise du coronavirus est hélas survenue au moment où le Ministère de la Culture avait commencé à mettre en oeuvre les premières mesures inspirées du rapport, mais dans une mesure bien insuffisante pour les syndicats d’auteurs professionnels qui poussaient pour une adoption plus large. Depuis, la situation des artistes auteurs s’est encore dramatiquement aggravée et l’urgence ne fait une renforcer encore l’importance de la plupart des préconisations du rapport (voir à ce sujet le site de la Ligue des Auteurs Professionnels).

Il est, à mon sens, impératif que les bibliothèques soutiennent les auteur dans ce combat et elles laisseraient à mon sens passer une chance historique si elles ne le faisaient pas.

23 recommandations sur les droits des créateurs : Quels enjeux pour les bibliothèques et comment elles peuvent contribuer à les soutenir ?

Pourriez-vous nous expliquer ce qu’est le rapport Racine et le contexte de sa production ?

Il s’agit d’un rapport remis au Ministère de la Culture en janvier 2020. Intitulé « L’auteur et l’acte de création », il a été préparé par Bruno Racine, conseiller à la Cour des Comptes, qui a dirigé la Bibliothèque nationale de France de 2007 à 2016. Il comporte 23 recommandations visant à améliorer la situation des artistes-auteurs en adaptant le cadre réglementaire aux nouvelles réalités des métiers de la création.

L’origine de ce rapport est à chercher du côté d’une forte mobilisation des auteurs en France, qui dure depuis plusieurs années, en réaction à une dégradation continue de leurs conditions d’existence. En 2017, une réforme fiscale est intervenue, qui a encore fragilisé une large partie des auteurs luttant déjà contre la précarité. Pour faire face, les artistes-auteurs ont choisi d’agir en s’appuyant sur des syndicats, ce qui est assez nouveau en France. Traditionnellement, les intérêts des auteurs sont en effet plutôt représentés par des sociétés de gestion collective des droits.

La commande du rapport Racine est intervenue pour essayer de dénouer une situation qui devenait de plus en plus explosive, avec des appels des auteurs professionnels à boycotter de grands salons pour attirer l’attention sur leur situation. Elaboré au terme d’une large consultation, le rapport Racine était très attendu et il dresse un tableau sombre de la situation des auteurs en France. Dans certains secteurs comme la bande dessinée, pourtant économiquement en progression, près d’un tiers des auteurs vivent en dessous du seuil de pauvreté et le taux grimpe à 50% pour les femmes. La France est souvent présentée comme « le pays du droit d’auteur », mais cette réputation dissimule une situation de crise profonde pour les créateurs.

Quelle analyse peut-on faire des recommandations de ce rapport ?

Le plus grand apport de ce rapport est de montrer que la subsistance des auteurs ne dépend pas uniquement du seul droit d’auteur, mais d’un dispositif institutionnel beaucoup plus complexe, où les questions de fiscalité et de protection sociale jouent un rôle déterminant. Il montre aussi que les artistes-auteurs ne disposent pas d’un véritable statut professionnel, comme si leur activité ne constituait pas un métier à part entière. Pour remédier à cette lacune, Le rapport Racine propose de créer un tel statut, notamment pour faciliter l’accès des auteurs au bénéfice de droits sociaux (assurance-maladie, formation, retraite, etc.).

Plus encore, le rapport Racine défend l’idée que les artistes-auteurs ne devraient pas dépendre pour vivre uniquement de l’exploitation de leurs œuvres par les industries culturelles, mais aussi être rémunérés directement pour leur travail. Il propose pour cela la mise en place d’un « contrat de commande » qui obligerait les intermédiaires, comme les éditeurs ou les producteurs, à payer le travail de création en plus du versement de droits d’auteur.

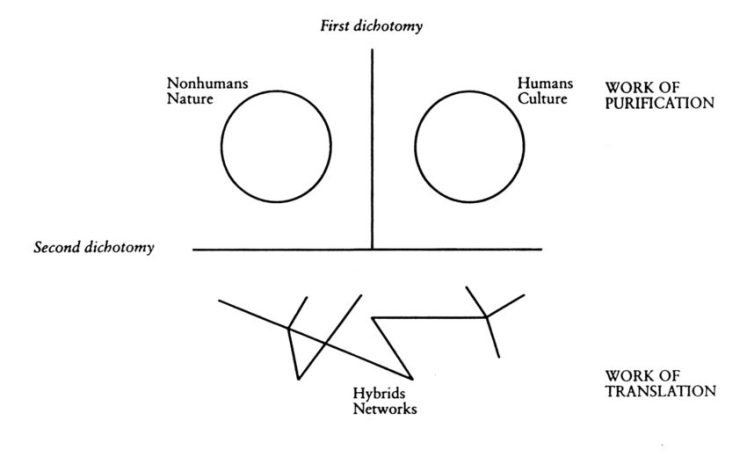

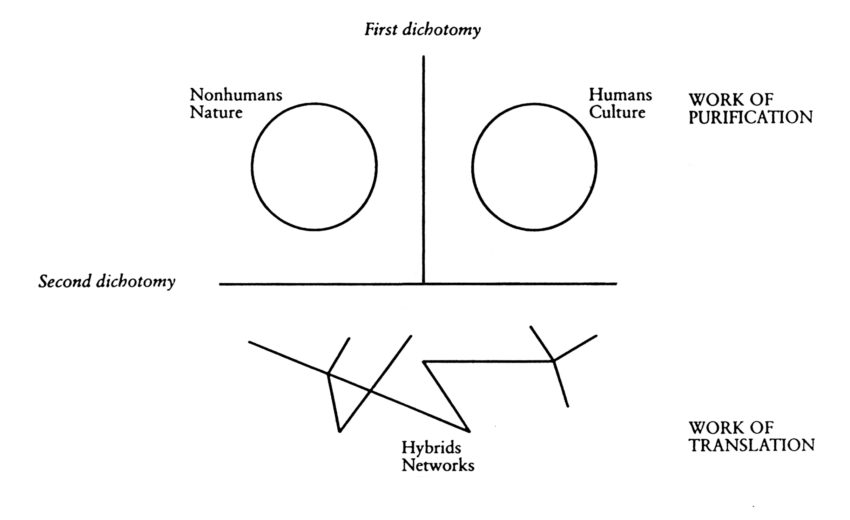

Cela constituerait un changement profond en France, car depuis l’époque de Beaumarchais et la Révolution française, la loi considère l’auteur comme un propriétaire tirant ses revenus de l’exploitation de son œuvre. Ce système permet certes théoriquement à l’auteur de bénéficier d’une rémunération, mais on est arrivé aujourd’hui au paradoxe que l’œuvre est mieux protégée que l’auteur et c’est elle qui constitue le véritable centre de gravité de la propriété intellectuelle…

Samantha Bailly, une autrice particulièrement impliquée dans les syndicats d’artistes-auteurs qui se sont mobilisés autour du rapport Racine, résume ainsi le changement de perspective que ce texte propose d’opérer : « l’amélioration de nos droits sociaux est liée à la reconnaissance des artistes-auteurs à la fois comme des propriétaires d’œuvres, mais aussi comme des travailleurs. Nous sommes bien des individus, et pas seulement des œuvres — nous avons des corps, nous mangeons, nous nous blessons, tombons malades, etc. C’est ce changement de paradigme que propose le rapport de Bruno Racine. »

Un autre point essentiel concerne les mécanismes de représentation des auteurs. Le rapport souligne de nombreux dysfonctionnements dans la manière dont les intérêts des artistes-auteurs sont défendus. Généralement, ce sont des sociétés de gestion collective que l’on entend beaucoup dans les débats publics autour de la création, notamment lorsque le droit d’auteur est concerné. Mais le rapport démontre que ces sociétés et les auteurs n’ont pas tout à fait les mêmes intérêts et il demande qu’une partie des sommes collectées par les premières servent à financer les syndicats d’auteurs. Il plaide également pour que ces syndicats soient plus largement associés à la définition des politiques culturelles, notamment à travers les différentes commissions mises en place par le Ministère de la Culture. Ces propositions ont été très mal reçues par les sociétés de gestion collective qui s’y sont vigoureusement opposées, ce qui tend à montrer que le rapport Racine a plutôt raison de souligner une divergence d’intérêts !

Les discussions sur le droit d’auteur seraient sans doute différentes si les créateurs pouvaient faire entendre leur voix plus directement. En 2018, une affaire a eu lieu en France s’est révélée très instructive. Une société de droits dans le domaine de l’édition a essayé de faire payer les lectures publiques en bibliothèque, y compris les Heures du Conte à destination des enfants. Cela a déclenché une forte opposition des bibliothécaires, mais aussi d’une partie des auteurs eux-mêmes qui, par le biais de syndicats, ont fait savoir qu’ils souhaitaient que ces usages en bibliothèque restent gratuits. Grâce à cette intervention directe des auteurs dans le débat, le projet des éditeurs a été abandonné.

Quelles sont les principaux enjeux de ce rapport pour les bibliothèques ?

A première vue, ce rapport paraît assez éloigné de l’activité des bibliothèques, mais celles-ci devraient s’y intéresser de près, car ses recommandations pourraient modifier en profondeur le paysage de la création.

Depuis plus de 20 ans, les bibliothèques sont mobilisées pour faire évoluer la règlementation sur le droit d’auteur, notamment par la reconnaissance de nouvelles exceptions adaptées à Internet et aux usages numériques. Que ce soit au niveau mondial ou international, ces débats sont très difficiles et les progrès restent lents, car les bibliothèques se heurtent à une opposition, menée surtout par des sociétés de gestion collective ou des représentants de gouvernement, qui soutiennent que ces exceptions menaceraient les auteurs dans leur capacité à vivre de la création.

Or le rapport Racine démontre de manière très claire que les vrais problèmes des auteurs sont ailleurs : ils résident surtout dans le déséquilibre du rapport de force avec des intermédiaires comme les éditeurs ou les producteurs, qui conduit à une répartition inéquitable de la valeur au sein même des filières culturelles. La précarité des auteurs découle aussi du fait que leur travail n’est pas bien reconnu, et donc pas bien rémunéré, car il est « invisibilisé » d’une certaine manière par la propriété intellectuelle sur laquelle les lois se focalisent.

A aucun moment le rapport Racine ne pointe la question du piratage des œuvres sur Internet comme la cause de la paupérisation des auteurs, pas plus qu’il n’indique que les exceptions au droit d’auteur fragiliseraient leur situation. En revanche, il adresse des critiques au fonctionnement des sociétés de gestion collective, en pointant par exemple les salaires trop élevés de leurs dirigeants ou le fait qu’elles redistribuent l’argent collecté à un trop petit nombre d’auteurs.

Ces conclusions intéressent en réalité directement les bibliothèques, car elles ouvrent la voie à de nouvelles discussions sur la réforme du système. Il est significatif qu’aucun des points discutés dans le rapport Racine n’ait réellement été débattu lors de l’élaboration de la nouvelle directive sur le droit d’auteur adoptée en 2019 par le Parlement européen. Les débats se sont encore une fois focalisés sur le renforcement de la propriété intellectuelle et sur la critique des nouvelles exceptions au droit d’auteur. Mais ce n’est pas ce texte qui permettra de rééquilibrer les relations entre les auteurs et les intermédiaires, comme le demande le rapport Racine…

Un point figure dans le rapport qui illustre très bien les fausses questions dans lesquelles les débats sur le droit d’auteur tombent souvent. En France, revient régulièrement dans le débat public l’idée d’instaurer un « domaine public payant » pour établir une sorte de taxe sur les utilisations commerciales des œuvres appartenant au domaine public. Le domaine public est un mécanisme qui bénéficie au premier chef aux bibliothèques et à leurs usagers, notamment à travers la numérisation des collections patrimoniales. Or le rapport Racine écarte sans ambiguïté cette idée du domaine public payant, en montrant qu’il rapporterait très peu aux auteurs tout en restreignant les usages et la diffusion de la culture. En revanche, le rapport pointe le fait qu’une part trop faible des aides à la création versées par le Ministère de la Culture ou les sociétés de gestion collective bénéficient directement aux artistes-auteurs. Ce n’est qu’un exemple parmi d’autres montrant comment de faux débats cachent souvent les vraies questions…

Quelles sont les premières étapes pour les bibliothèques pour soutenir ces principes au niveau national et international ?

Il est assez frappant de constater que les bibliothèques sont absentes du rapport Racine, alors pourtant qu’elles constituent aussi une source de revenus pour les auteurs. A travers les acquisitions de supports, les abonnements à des ressources numériques, mais aussi avec les sommes versées au titre du droit de prêt, les bibliothèques contribuent à la rémunération des créateurs. En France, il existe même un lien direct entre le droit de prêt et les droits sociaux des auteurs, car une partie des sommes versées par les bibliothèques au titre du droit de prêt sert à financer la retraite des auteurs de l’écrit.

Il est dommage – mais aussi très significatif – que le rapport Racine n’ait pas pris en compte ce lien, car cela révèle une certaine forme d’invisibilité des bibliothèques dans l’économie de la création. Trop souvent, les bibliothèques sont accusées de fragiliser le marché de la Culture en « cannibalisant les ventes », alors qu’aucune étude économique sérieuse n’a jamais démontré un tel phénomène. Bien au contraire, les bibliothèques pourraient contribuer plus largement au financement de la création si elles étaient mieux intégrées dans les systèmes de rémunération. Par exemple, le livre numérique se développe aujourd’hui de plus en plus en bibliothèque, mais sur des bases juridiquement fragiles, puisque la législation sur le prêt du livre papier ne s’applique pas et il a fallu réorganiser le système autour de négociations contractuelles avec les éditeurs. Du coup, l’offre à destination des bibliothèques reste lacunaire, mais surtout, le système légal du droit de prêt est mis de côté, ce qui ne permet pas de contribuer à financer les droits sociaux des auteurs…

On pourrait imaginer une refonte du système, de manière à ce que les bibliothèques puissent mettre à disposition plus facilement des contenus pour leurs utilisateurs, comme le propose par exemple le traité sur les bibliothèques défendu par l’IFLA auprès de l’OMPI. En contrepartie, de nouvelles rémunérations seraient logiquement versées aux ayants droit. Mais si l’on suit le rapport Racine, il faudrait être très attentif à ce que ces sommes aillent bien aux auteurs et qu’une partie soit utilisée pour financer leurs droits sociaux et leurs organisations syndicales.

Ce rapport ouvre en réalité la voie à de nouvelles discussions entre les auteurs et les bibliothèques. Pour cela, il faudrait mieux faire connaître le rôle que les bibliothèques jouent déjà pour soutenir la création et réfléchir à de nouvelles manières dont les activités des bibliothèques pourraient directement soutenir les créateurs dans l’exercice de leurs droits. On a trop souvent opposé les droits des auteurs et ceux des utilisateurs, comme s’ils étaient incompatibles. Le temps est venu à présent de trouver des articulations qui permettront de les renforcer mutuellement.